Na, erwischt! Du bist wohl ein bisschen zu neugierig, was?

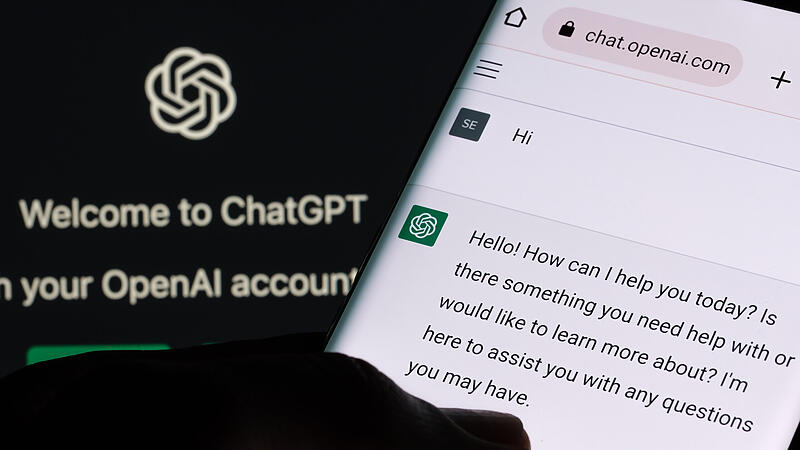

ChatGPT

Wie gefährlich ist Künstliche Intelligenz?

Bamberg

– Steht die Menschheit kurz vor ihrer eigenen Abschaffung? Prof. Ute Schmid von der Uni Bamberg erklärt, wie sich das Horrorszenario vermeiden lässt.

Artikel anhören